长短期记忆网络(LSTM)原理解析

2023-07-20 18:23:32 106浏览

长短期记忆网络(Long Short-Term Memory,简称LSTM)是一种常用于处理序列数据的深度学习模型。它在循环神经网络(Recurrent Neural Network,RNN)的基础上进行了改进,旨在解决传统RNN中的梯度消失和梯度爆炸问题,同时能够更好地捕捉长期依赖关系。

LSTM的核心思想是引入了称为"门"(gates)的结构,这些门可以选择性地控制信息的流动。LSTM单元由三个主要的门组成:输入门(input gate)、遗忘门(forget gate)和输出门(output gate)。

下面是对LSTM中每个门的详细说明:

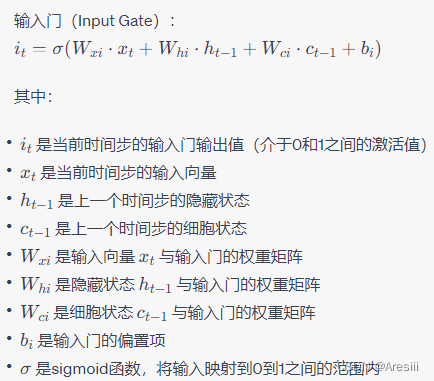

一)输入门(Input Gate)

输入门控制着新输入信息的流入程度。它通过使用sigmoid激活函数将当前输入与之前的记忆状态进行组合,得到一个介于0和1之间的值。接下来,通过使用另一个tanh激活函数,将当前输入与记忆状态的组合作为新的记忆候选值。

输入门控制了当前时间步的输入信息对于当前时间步的状态更新的影响程度。当输入门接近1时,输入的影响较大;当输入门接近0时,输入的影响较小。输入门还会结合遗忘门和细胞状态,决定细胞状态的更新。

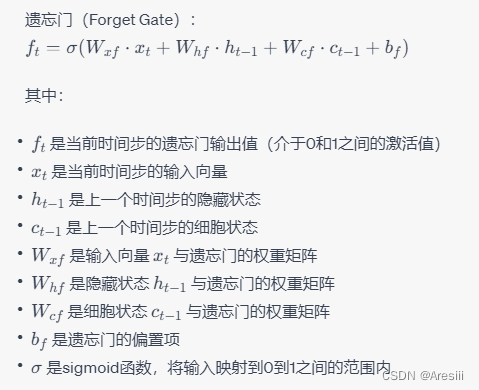

二)遗忘门(Forget Gate)

遗忘门控制着之前的记忆状态中哪些信息应该被遗忘。它通过使用sigmoid激活函数来评估上一个记忆状态与当前输入的组合,得到一个介于0和1之间的值。这个值将与之前的记忆状态相乘,以确定哪些信息需要被保留下来。

当遗忘门接近1时,细胞状态的信息被完全保留;当遗忘门接近0时,细胞状态的信息被完全遗忘。

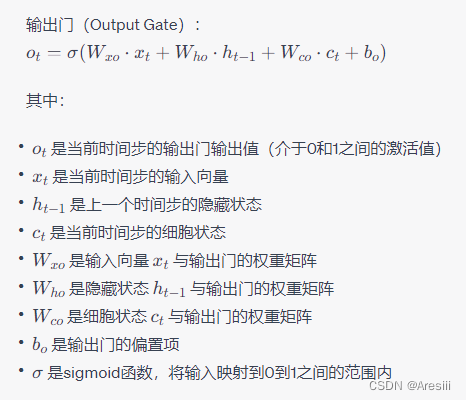

三)输出门(Output Gate)

输出门控制着当前时刻的输出值。它通过使用sigmoid激活函数来评估当前的输入和记忆状态的组合,得到一个介于0和1之间的值。同时,使用tanh激活函数来处理当前的记忆状态,并与输出门的值相乘,得到LSTM的当前输出。

当输出门接近1时,细胞状态的信息被充分输出;当输出门接近0时,细胞状态的信息被抑制,不被输出到隐藏状态中。

下面是使用Python和Keras库实现一个简单的LSTM模型的示例代码:

import numpy as np

from keras.models import Sequential

from keras.layers import LSTM, Dense

# 准备输入序列数据

data = [[0.1, 0.2, 0.3, 0.4, 0.5],

[0.2, 0.3, 0.4, 0.5, 0.6],

[0.3, 0.4, 0.5, 0.6, 0.7],

[0.4, 0.5, 0.6, 0.7, 0.8]]

data = np.array(data) # 转换为NumPy数组

# 将输入序列转换为LSTM的输入格式:[样本数, 时间步, 特征维度]

data = np.reshape(data, (data.shape[0], data.shape[1], 1))

# 准备目标数据

target = [0.6, 0.7, 0.8, 0.9]

target = np.array(target)

# 创建LSTM模型

model = Sequential()

model.add(LSTM(64, input_shape=(data.shape[1], 1))) # 添加一个LSTM层,64个隐藏单元

model.add(Dense(1)) # 添加一个全连接层,输出一个值

# 编译模型

model.compile(loss='mean_squared_error', optimizer='adam')

# 训练模型

model.fit(data, target, epochs=100, batch_size=1, verbose=2)

# 使用模型进行预测

test_data = [[0.5, 0.6, 0.7, 0.8, 0.9]]

test_data = np.array(test_data)

test_data = np.reshape(test_data, (test_data.shape[0], test_data.shape[1], 1))

prediction = model.predict(test_data)

print("预测结果:", prediction)

这段代码实现了一个简单的LSTM模型,输入数据是一个包含5个时间步的序列,目标数据是对应的下一个时间步的值。模型包含一个LSTM层和一个全连接层。在训练过程中,使用均方误差作为损失函数,使用Adam优化器进行模型参数的更新。训练完成后,使用模型对一个新的序列进行预测,并打印出预测结果。

请注意,这只是一个简单的示例代码,实际应用中可能需要根据具体情况进行适当的修改和调整,包括数据预处理、模型结构、超参数选择等。

通过以上的门机制,LSTM能够对信息进行选择性地存储和遗忘,并在序列中传递重要的信息。这使得LSTM网络能够更好地处理长序列,同时减轻了梯度消失和梯度爆炸问题。

除了上述的核心门结构,LSTM还有一些变体和扩展,如双向LSTM(Bidirectional LSTM)、多层LSTM(Multi-layer LSTM)等。这些变体可以增强LSTM在不同任务中的表达能力和性能。

总结来说,LSTM是一种能够有效地处理序列数据、捕捉长期依赖关系的深度学习模型。它通过引入输入门、遗忘门和输出门的机制,选择性地存储和遗忘信息,从而在处理序列数据时取得了很好的效果。

好博客就要一起分享哦!分享海报

此处可发布评论

评论(0)展开评论

展开评论